Dentro de una computadora de IA: por qué los sistemas modernos de inteligencia artificial consumen tanta memoria

Cómo se ve realmente un servidor de IA cuando se abre la cubierta

En este momento hay mucho ruido sobre la IA usando “demasiada memoria”. Los precios están subiendo. El suministro es limitado. Todo el mundo dice que la demanda está explotando. Probablemente ya lo hayas leído.

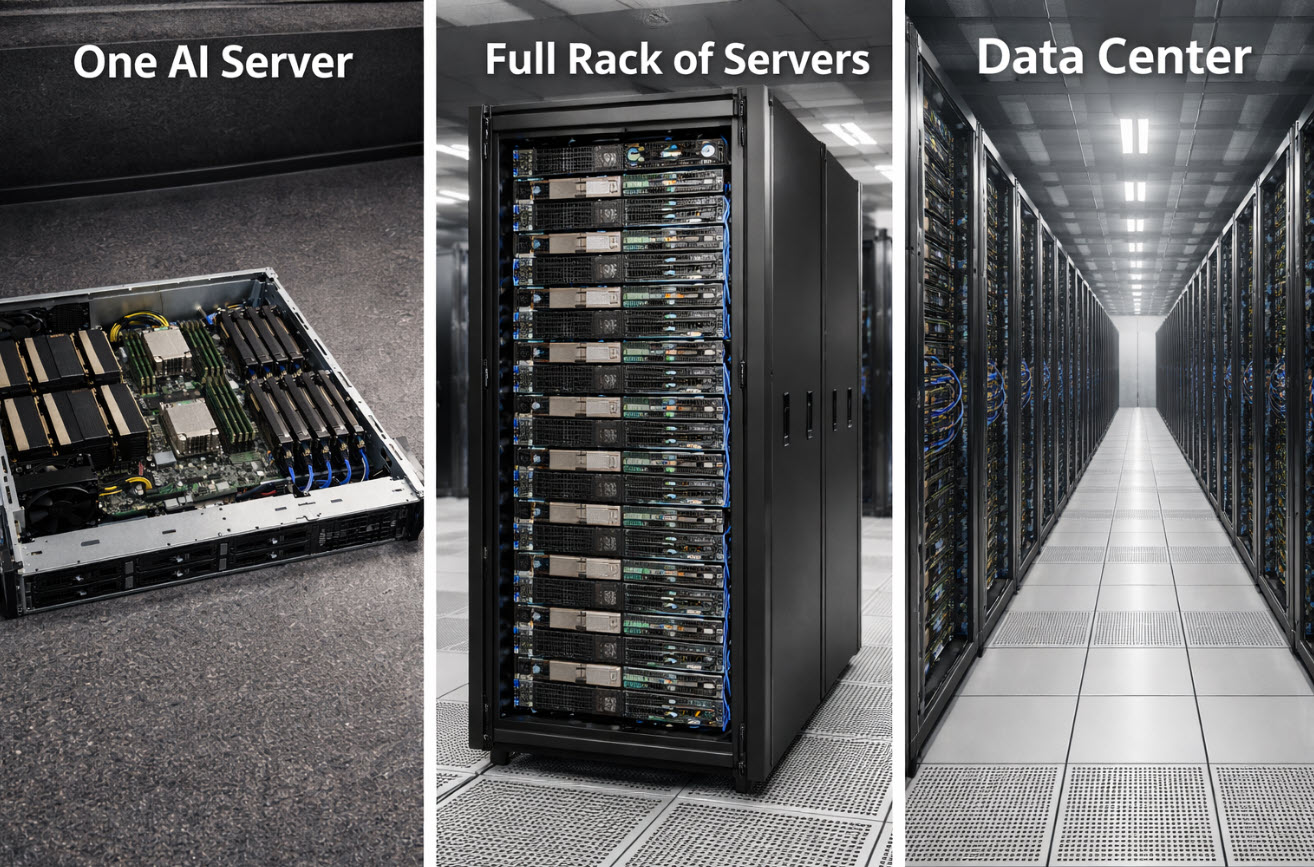

Pero la mayoría de lo que se escribe omite la parte más importante: cómo es físicamente una computadora de IA y por qué necesita tanta memoria en primer lugar. No en gráficos abstractos ni en previsiones de mercado, sino en términos que se puedan visualizar. Una vez que entiendes lo que realmente consume un solo sistema de IA, el resto de la historia deja de sonar dramática y empieza a sonar inevitable.

Hace poco terminé explicando esto en un lugar que no tiene nada que ver con los centros de datos. Estaba en la escuela de mi hijo durante un “día de padres”, de pie en un aula, y algunos estudiantes comenzaron a hacer preguntas sobre la IA. No preguntas sobre chatbots. Preguntas reales. ¿Cómo se ve la computadora? ¿A dónde van los datos? ¿Por qué todo el mundo sigue hablando de “memoria” como si fuera lo único que importa?

Así que empecé por lo básico. Les pedí que imaginaran una computadora normal. Una que usarían en casa. Tiene un procesador que hace los cálculos, memoria que mantiene lo que está trabajando en ese momento y almacenamiento que guarda las cosas para después. Tareas. Fotos. Juegos. Todo tiene su lugar.

Luego les expliqué que la IA sigue siendo una computadora, pero no una que hace una pequeña tarea a la vez. Está ejecutando enormes cantidades de cálculos sobre enormes cantidades de datos, una y otra vez, comparando patrones, ajustando pesos, guardando puntos de control, y haciéndolo todo tan rápido que esperar al almacenamiento se convierte en el mayor enemigo.

Por eso la memoria se convierte en la protagonista. No porque esté de moda. Sino porque, sin suficiente memoria y almacenamiento rápido, las GPU se quedan esperando, y eso es como comprar un auto de carreras y dejarlo estacionado porque la carretera es demasiado estrecha.

Un servidor de IA no es una sola torre de escritorio. Se parece más a una estación de trabajo extremadamente compacta llevada al extremo. Un servidor de entrenamiento típico hoy en día tiene ocho GPU, y cada GPU cuenta con su propia memoria ultrarrápida solo para poder seguir el ritmo de los cálculos. Además, el servidor dispone de un gran conjunto de memoria del sistema para alimentar a las GPU sin cuellos de botella, y luego una serie de SSD NVMe dentro del chasis para preparar los conjuntos de datos y escribir los resultados intermedios.

Cuando se ve una lista real de materiales de una de estas máquinas, no es algo sutil. Se trata de cientos de gigabytes de memoria de GPU, a menudo medio terabyte hasta varios terabytes de RAM del sistema, y decenas de terabytes de almacenamiento SSD NVMe dentro de un solo servidor. No a través de la red. No en un SAN compartido. Dentro de una sola unidad.

Ese suele ser el momento en que la sala se queda en silencio, porque la escala empieza a sentirse real. Un solo servidor puede tener más almacenamiento flash del que la mayoría de los hogares tendrá jamás. Y la IA no escala agregando un servidor y dando por terminado el trabajo. Escala agregando docenas o cientos a la vez, porque entrenar modelos grandes es un trabajo en equipo. Una sola máquina no carga con todo.

Entonces, si un solo servidor de IA consume silenciosamente veinte o treinta terabytes de flash, ¿qué ocurre cuando se despliegan cien de ellos? De repente se habla de petabytes de NAND flash consumidos en una sola implementación, y eso antes de contar los sistemas de almacenamiento compartido, la replicación, las copias de seguridad, el registro y las actualizaciones de “lo necesitamos más rápido que el trimestre pasado” que comienzan en cuanto el clúster entra en producción.

Aquí es donde las historias sobre la escasez de memoria dejan de sonar a exageración y empiezan a sonar como simple aritmética. Las fábricas de memoria no se construyen de la noche a la mañana. El flash y la DRAM requieren años de planificación, construcción, calificación y puesta en marcha. Incluso cuando los titulares hablan de fluctuaciones en los precios de la memoria, las limitaciones estructurales de la oferta no desaparecen cuando la demanda llega en bloques del tamaño de un centro de datos.

Luego llega la segunda ola: los sistemas a escala de rack. En lugar de tratar cada servidor como una máquina independiente, los fabricantes ahora construyen racks completos que se comportan como una sola computadora. Docenas de GPU en un rack, enormes conjuntos de memoria, filas de SSD colocados uno junto a otro. Las distancias se miden en centímetros, no en metros, porque la velocidad importa tanto.

En ese punto ya no se pregunta: “¿Cuánta memoria necesita una computadora?”. La pregunta pasa a ser: “¿Cuánta memoria necesita un rack?”. Y eso es exactamente por qué la electrónica de consumo siente la presión. No porque los consumidores de repente estén comprando el doble de teléfonos, sino porque apareció un comprador diferente, con una escala de demanda completamente distinta, que compra en bloques que parecen centros de datos completos.

A nivel de almacenamiento, esto también explica por qué suposiciones de larga data sobre el comportamiento del flash están empezando a romperse. Cuando las cargas de trabajo de IA dominan la demanda, distinciones como MLC frente a TLC NAND dejan de ser académicas y comienzan a afectar de forma muy real la disponibilidad, la durabilidad y las decisiones de asignación.

Los niños no necesitaban una clase sobre la cadena de suministro para entenderlo. Solo necesitaban la imagen. Una caja se convierte en una fila. Una fila se convierte en un rack. Un rack se convierte en una sala. Una sala se convierte en un edificio. Una vez que ves la IA como infraestructura y no como magia, la historia de la memoria se vuelve física, mecánica y predecible.

Y ese es el punto. No se trata de una escasez misteriosa. Es una colisión predecible entre capacidades que tardan años en construirse y una demanda que puede aparecer de la noche a la mañana en forma de unos cuantos camiones cargados de servidores rumbo a un edificio del tamaño de un almacén.

Dicho de forma sencilla: la IA no solo está usando más memoria que antes. Está redefiniendo qué significa siquiera una cantidad “normal” de memoria.

Cómo se creó este artículo

Biografía del autor más abajo — Especialista en sistemas de almacenamiento USB y duplicación

Este artículo fue redactado con asistencia de IA para la estructura y la redacción, y luego revisado, editado y finalizado por un autor humano para mejorar la claridad, la precisión y la relevancia en el mundo real.

Divulgación de la imagen

La imagen en la parte superior de este artículo fue generada utilizando inteligencia artificial con fines ilustrativos. No es una fotografía de entornos reales.

Tags: centros de datos, demanda de SSD, escasez de memoria, infraestructura de IA, NAND flash